EINE KURZE GESCHICHTE DER

KÜNSTLICHEN INTELLIGENZ

Die Geschichte der Künstlichen Intelligenz (KI) ist geprägt von technologischen Durchbrüchen und maßgeblichen Momenten, die unser Verständnis von maschinellem Lernen, Entscheidungsfindung und der Mensch-Maschine-Interaktion nachhaltig beeinflusst haben.

Seit den ersten Konzepten der 1950er Jahren hat sich die KI von einer theoretischen Disziplin zu einer Schlüsseltechnologie entwickelt, die nahezu alle Bereiche des modernen Lebens berührt.

Die Geschichte der KI ist eine faszinierende Reise von den ersten theoretischen Konzepten bis hin zu den heutigen hochentwickelten Systemen. Sie spiegelt den menschlichen Wunsch wider, intelligente Maschinen zu schaffen und zeigt zugleich die Notwendigkeit, diese Technologien verantwortungsvoll zu entwickeln und einzusetzen.

Frühe Konzepte und die Geburtsstunde der KI (1950er und 1960er Jahre)

Die Anfänge der KI reichen bis in die Mitte des 20. Jahrhunderts zurück, als Mathematiker und Informatiker die Möglichkeit untersuchten, Maschinen zu schaffen, die menschenähnlich denken können.

Ein zentraler Vorreiter war der britische Mathematiker Alan Turing, der 1950 in seinem Artikel "Computing Machinery and Intelligence" die Frage stellte: „Können Maschinen denken?". Er führte den Turing-Test ein, um zu bestimmen, ob eine Maschine durch sprachliche Kommunikation von einem Menschen unterscheidbar ist.

Ein weiterer Meilenstein war die Dartmouth-Konferenz von 1956, organisiert von John McCarthy, Marvin Minsky, Nathaniel Rochester und Claude Shannon. Diese Veranstaltung gilt als offizieller Beginn des Forschungsfeldes Künstliche Intelligenz. Hier wurde der Begriff "Artificial Intelligence" geprägt und die Vision entwickelt, Maschinen zu schaffen, die intelligente Aufgaben wie Problemlösen, Lernen und Sprachverarbeitung übernehmen können.

ELIZA und die frühe Sprachverarbeitung

(1960er Jahre)

In den 1960er Jahren begann die praktische Umsetzung von KI-Konzepten, insbesondere im Bereich der Sprachverarbeitung. Joseph Weizenbaum entwickelte 1966 ELIZA, ein Programm, das einen psychotherapeutischen Dialog simulierte, indem es einfache Mustererkennungsalgorithmen nutzte, um auf Benutzereingaben zu reagieren.

Der Name „ELIZA" ist eine Anspielung auf Eliza Doolittle, die Hauptfigur aus dem Theaterstück und späteren Film „My Fair Lady", das auf George Bernard Shaws Stück „Pygmalion" basiert. In der Geschichte wird Eliza, eine einfache Blumenverkäuferin mit starkem Akzent, von Professor Henry Higgins in die Kunst der gehobenen Sprache eingeführt, wodurch sie sich als kultivierte Dame ausgibt. Weizenbaum wählte diesen Namen, weil sein Programm ähnlich wie Eliza Doolittle in der Lage war, ohne echtes Verständnis der Sprache zu wirken, als könne es gehobene Konversation führen.

Das Programm ELIZA imitierte also, ähnlich wie Eliza in „My Fair Lady", eine tiefere Fähigkeit, die es tatsächlich nicht besaß, und konnte lediglich vorgefertigte Antworten auf bestimmte Schlüsselwörter geben.

Obwohl ELIZA keine tiefgreifende Intelligenz besaß, zeigte es, wie Maschinen die Illusion menschlicher Interaktion erzeugen können. Dies legte den Grundstein für die spätere Entwicklung fortschrittlicher Sprachmodelle, die auf komplexeren Algorithmen basieren, aber immer noch auf Mustern der Kommunikation aufbauen.

Die Ära der Expertensysteme

(1970er und 1980er Jahre)

In den 1970er und 1980er Jahren lag der Fokus der KI-Forschung auf Expertensystemen, die darauf abzielten, menschliche Experten zu unterstützen oder zu ersetzen. Diese Systeme speicherten strukturiertes Wissen in Form von Wenn-Dann-Regeln und trafen auf dieser Grundlage Entscheidungen.

Die Idee hinter Expertensystemen war es, die Problemlösungsfähigkeiten eines Experten auf Maschinen zu übertragen, indem explizites Wissen und logische Schlussfolgerungen genutzt wurden.

Das erste bedeutende Expertensystem war DENDRAL, das 1965 von Edward Feigenbaum und Joshua Lederberg an der Stanford University entwickelt wurde. DENDRAL wurde speziell entwickelt, um Chemikern bei der Identifizierung unbekannter organischer Moleküle zu helfen. Das System analysierte Spektraldaten von Molekülen und nutzte eine regelbasierte Methode, um mögliche molekulare Strukturen zu bestimmen.

DENDRAL gilt als bahnbrechend, da es den Entscheidungsprozess der Chemiker automatisierte und auf einer tiefen Wissensbasis in der Chemie aufbaute. Durch den Einsatz von Algorithmen konnte DENDRAL aus den Daten schließen, welche molekulare Struktur am wahrscheinlichsten zutraf, und damit den Chemikern die komplexe Aufgabe der Strukturaufklärung erleichtern.

Auf der Grundlage der Erkenntnisse von DENDRAL wurde in den 1970er Jahren das medizinische Expertensystem MYCIN entwickelt. MYCIN wurde entworfen, um Ärzten bei der Diagnose von Blutinfektionen zu helfen und Empfehlungen für geeignete Antibiotika zu geben. Das System war besonders nützlich in Situationen, in denen schnelles Handeln und präzise Entscheidungen gefragt waren.

Es arbeitete mit einer Reihe von Wenn-Dann-Regeln, die auf medizinischem Wissen basierten und konnte dadurch spezifische Bakterien identifizieren, die Infektionen verursachten. Zudem gab MYCIN Hinweise zur Dosierung und Wahl der Antibiotika basierend auf den eingegebenen Symptomen und Testergebnissen.

Trotz ihrer Erfolge waren Expertensysteme auf fest kodierte Regeln und explizites Wissen angewiesen, was ihre Flexibilität einschränkte. Diese Systeme arbeiteten auf der Grundlage von boolescher Logik, bei der Variablen nur "wahr" oder "falsch" sein konnten. Damit waren sie ungeeignet für dynamische und komplexe Umgebungen, in denen neue oder unvorhergesehene Situationen auftraten.

Rückschläge und erneuter Aufschwung

(1980er bis 1990er Jahre)

In den späten 1980er Jahren erlebte die KI-Forschung eine Phase der Ernüchterung, die als „KI-Winter" bezeichnet wurde. Viele der hochgesteckten Erwartungen, die durch die frühen Erfolge von Expertensystemen und regelbasierten Ansätzen geweckt worden waren, konnten nicht erfüllt werden.

Diese Systeme stießen an ihre Grenzen, da sie stark von explizitem Wissen und fest kodierten Regeln abhingen. In dynamischen, realen Umgebungen, in denen neue Situationen oder Daten auftraten, waren solche Systeme oft nicht flexibel genug. Diese Limitierungen führten zu einem Rückgang der Investitionen und des Interesses an KI, und viele Forscher begannen, sich anderen Technologien zuzuwenden.

Trotz dieses Rückschlags gab es auch in den 1990er Jahren bedeutende Fortschritte in der KI-Forschung. Eine der Schlüsselentwicklungen dieser Zeit war die Wiederentdeckung und Weiterentwicklung von neuronalen Netzen. Diese Modelle, inspiriert von der Funktionsweise des menschlichen Gehirns, waren bereits in den 1950er Jahren theoretisch eingeführt worden, konnten jedoch aufgrund begrenzter Rechenkapazität und mangelnder Daten in den frühen Jahren nicht in die Praxis umgesetzt werden.

In den 1980er Jahren wurden neuronale Netze durch die Einführung des Backpropagation-Algorithmus durch Forscher wie Geoffrey Hinton, David Rumelhart und Ronald Williams weiterentwickelt. Backpropagation ermöglichte es, Fehler in neuronalen Netzen zu korrigieren und die Netzwerke dadurch zu „trainieren".

Neuronale Netze bestehen aus mehreren Schichten künstlicher Neuronen, die miteinander verbunden sind.

Die Grundidee ist, dass diese Netzwerke Daten verarbeiten können, indem sie Gewichtungen zwischen den Neuronen anpassen und Muster in den Daten erkennen. Das Besondere an neuronalen Netzen ist ihre Fähigkeit, aus Daten zu lernen, anstatt sich auf explizite Regeln zu verlassen, wie es bei den Expertensystemen der Fall war. Dadurch waren sie deutlich flexibler und konnten in komplexen, dynamischen Umgebungen besser arbeiten.

Mit der Verfügbarkeit leistungsstärkerer Computer und der zunehmenden Verfügbarkeit großer Datenmengen, die in den 1990er Jahren durch das Internet und die Digitalisierung erzeugt wurden, fand die KI-Forschung zu neuem Leben. Statt auf vordefinierte Regeln zu setzen, verlagerte sich der Fokus der Forschung auf statistische Modelle und maschinelles Lernen. Diese Modelle konnten aus großen Datensätzen Muster erkennen und Vorhersagen treffen, ohne dass menschliche Experten explizit eingreifen mussten.

Ein bedeutender Durchbruch in dieser Zeit war der Sieg des Schachcomputers Deep Blue von IBM über den Schachweltmeister Garry Kasparov im Jahr 1997. Deep Blue verwendete keine neuronalen Netze, sondern eine Kombination aus Brute-Force-Suche und ausgeklügelten Heuristiken, um die besten Züge im Schachspiel zu finden. Trotzdem zeigte dieser Erfolg der Welt, dass Maschinen in der Lage waren, auch in strategisch komplexen Spielen mit den besten menschlichen Spielern zu konkurrieren. Es war ein symbolischer Moment, der das Vertrauen in die Möglichkeiten der KI erneuerte.

Die Ära des Deep Learning und neuronaler Netze (2000er bis 2010er Jahre)

Mit dem Aufkommen des Deep Learning in den frühen 2000er Jahren erlebte die KI eine Transformation. Deep Learning, basierend auf tiefen neuronalen Netzen, ermöglichte es Maschinen, Muster aus großen Datenmengen zu erkennen und komplexe Aufgaben wie Bild- und Spracherkennung zu bewältigen. Fortschritte in der Computer Vision erlaubten es Maschinen, Objekte in Bildern und Videos zu identifizieren.

In den frühen Jahren der neuronalen Netze gab es jedoch auch erhebliche Herausforderungen. Eines der größten Probleme war das Vanishing-Gradient-Problem, das es erschwerte, tiefe neuronale Netze mit vielen Schichten effektiv zu trainieren. Dieses Problem führte dazu, dass die Aktualisierung der Gewichtungen in den unteren Schichten des Netzes nahezu unmöglich wurde, was das Lernen tiefgehender Merkmale behinderte. Diese Hürde verhinderte lange Zeit die Entwicklung leistungsfähigerer neuronaler Netze.

Der Durchbruch des Deep Learning wurde durch die Verfügbarkeit großer Datenmengen und leistungsfähiger GPUs ermöglicht. Neuronale Netze konnten immer tiefere Strukturen erlernen, was zu signifikanten Fortschritten in maschinellem Sehen, natürlicher Sprachverarbeitung und autonomem Fahren führte.

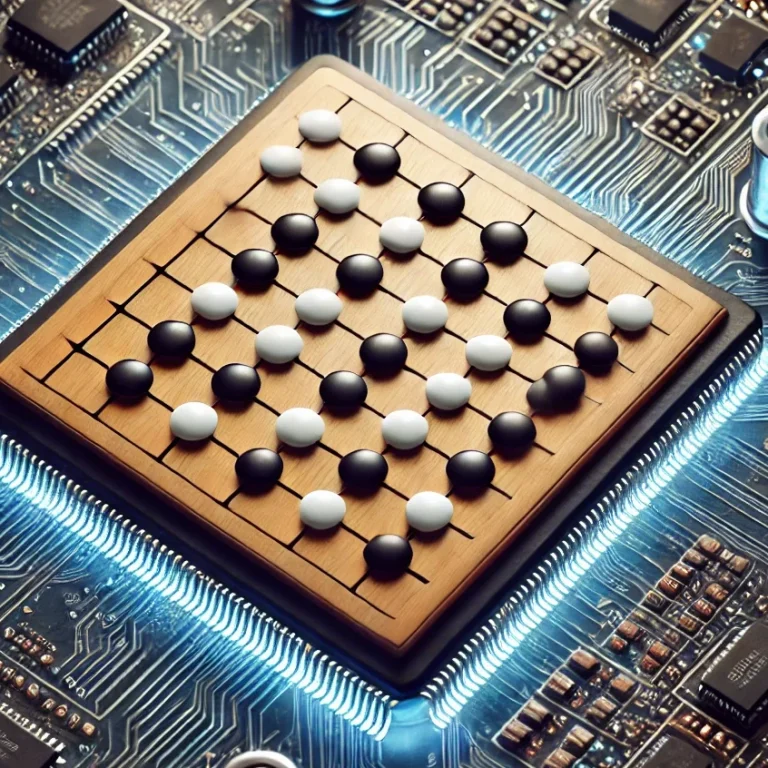

Ein beeindruckendes Beispiel war AlphaGo von DeepMind, das 2016 den Weltmeister im Go-Spiel, Lee Sedol, besiegte. Go gilt als eines der komplexesten Brettspiele, und der Erfolg von AlphaGo demonstrierte die Fähigkeit von KI, strategisches Denken zu simulieren.

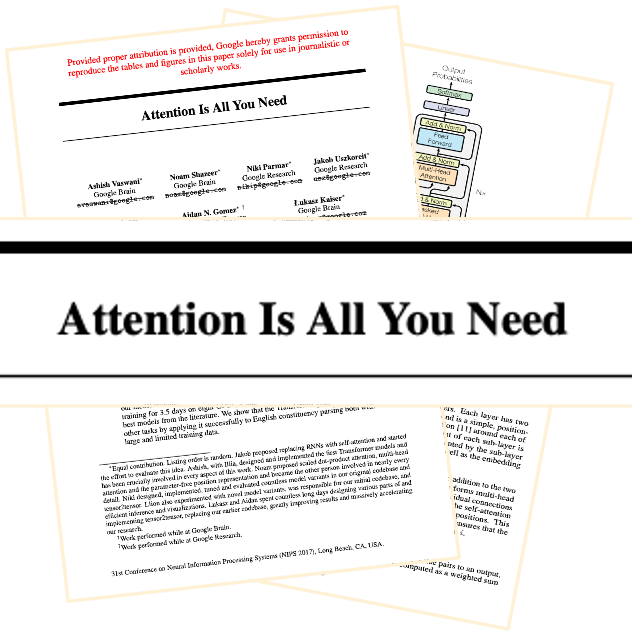

Der Durchbruch von 2017: "Attention is All You Need" und die Revolution der Transformer-Modelle

Das Jahr 2017 markierte einen Wendepunkt, als Google den Forschungsartikel "Attention is All You Need" veröffentlichte. Dieser stellte die Transformer-Architektur vor, die die Grundlage für moderne KI-Entwicklung bildet. Zuvor basierten viele fortschrittliche Natural Language Processing (NLP)-Modelle auf rekurrenten neuronalen Netzen (RNNs) und Long Short-Term Memory (LSTM)-Modellen, die Schwierigkeiten bei der Verarbeitung langer Textsequenzen hatten.

Der Transformer unterschied sich durch den Einsatz von Attention-Mechanismen, die es dem Modell ermöglichen, sich gleichzeitig auf verschiedene Teile eines Textes zu konzentrieren, unabhängig von ihrer Position. Dies ermöglichte es, komplexe Beziehungen und Zusammenhänge in langen Texten zu erkennen.

Der Self-Attention-Mechanismus, ein zentrales Konzept des Transformers, erlaubte es, den Kontext jedes Wortes umfassend zu verstehen und präzisere Vorhersagen zu generieren.

Die Veröffentlichung dieses Artikels eröffnete eine neue Ära im maschinellen Lernen und war maßgeblich verantwortlich für die Fortschritte in der Verarbeitung natürlicher Sprache.

Moderne KI und die Ära der großen Sprachmodelle (2020er Jahre)

In den 2020er Jahren entwickelte sich eine neue KI-Ära im Bereich der großen Sprachmodelle (Large Language Models) und der Verarbeitung natürlicher Sprache.

Besonders die von OpenAI entwickelten Transformer-Modelle wie GPT-3 und später GPT-4 setzten neue Standards in der Fähigkeit von Maschinen, menschenähnliche Texte zu generieren und komplexe Fragen präzise zu beantworten.

Im Jahr 2022 markierte OpenAI mit der Einführung von ChatGPT, basierend auf der GPT-3.5-Architektur, einen weiteren Wendepunkt. ChatGPT erweiterte die natürlichen Sprachfähigkeiten der KI erheblich, insbesondere durch den Einsatz von Reinforcement Learning from Human Feedback (RLHF).

Diese Technik ermöglichte es dem Modell, auf menschliches Feedback zu reagieren und seine Antworten kontinuierlich zu verbessern, indem es kontextbezogene und sinnvolle Reaktionen lieferte.

ChatGPT bewies seine Vielseitigkeit, indem es nicht nur komplexe Fragen beantwortete, sondern auch kreative Texte generierte und technische Erklärungen verständlich darstellte.

Dank seiner Benutzerfreundlichkeit und der Fähigkeit, in natürlicher Sprache zu kommunizieren, fand ChatGPT rasch Verbreitung und wurde in zahlreichen Bereichen wie Kundensupport, Content-Erstellung und Bildung eingesetzt.

Die Einführung dieses Modells zeigte das immense Potenzial von KI in alltäglichen Anwendungen und setzte neue Maßstäbe für die Mensch-Maschine-Interaktion, indem sie den Einsatz von KI in verschiedensten Lebensbereichen zugänglicher machte.

Die Zukunft der Künstlichen Intelligenz

Trotz enormer Fortschritte steht die KI weiterhin vor Herausforderungen. Ethische Fragen, Bias in KI-Systemen, Datenschutz und Transparenz sind zentrale Themen in Forschung und Entwicklung. Es bleibt abzuwarten, wie KI-Systeme gestaltet werden, um verantwortungsvoll einsetzbar zu sein und zum Wohl der Menschheit beizutragen.

Ein weiteres bedeutendes Forschungsfeld ist die Entwicklung von Künstlicher Allgemeiner Intelligenz (AGI), die in der Lage sein soll, eine Vielzahl von Aufgaben genauso gut oder besser als Menschen zu bewältigen.

Während heutige KI-Modelle, bekannt als Künstliche Enge Intelligenz (ANI), auf spezialisierte Aufgaben ausgerichtet sind, könnte AGI flexibel und intelligent auf unterschiedlichste Herausforderungen reagieren. Darüber hinaus gibt es das Konzept der Künstlichen Superintelligenz (ASI), die die Fähigkeiten menschlicher Intelligenz weit übertreffen würde.

Tiefgehende Informationen zu den Konzepten ANI, AGI und ASI finden sich in einem gesonderten Deep Dive.

i.know Conversations

"From Turing to Transformers:

A Brief History of Artificial Intelligence"

i.know Conversations sind englischsprachige PodCast Videos

zu ausgewählten I.AI Academy Themen.

©Urheberrecht. Alle Rechte vorbehalten. Datenschutz. Impressum.

Wir benötigen Ihre Zustimmung zum Laden der Übersetzungen

Wir nutzen einen Drittanbieter-Service, um den Inhalt der Website zu übersetzen, der möglicherweise Daten über Ihre Aktivitäten sammelt. Bitte überprüfen Sie die Details in der Datenschutzerklärung und akzeptieren Sie den Dienst, um die Übersetzungen zu sehen.